A IA e a Educação Combinam? Perspectiva da Jala University

Por Rolando Lora, da equipe de Pesquisa e Desenvolvimento da Jala University.

A IA Generativa realmente dominou as conversas no último ano, evocando um espectro de sentimentos que vão do ceticismo a uma mistura de otimismo e pessimismo. Ao refletirmos sobre o último ano, torna-se evidente que o mundo testemunhou as aplicações práticas e os efeitos abrangentes da Inteligência Artificial em vários aspectos de nossas vidas.

No meio dessa evolução tecnológica, uma questão premente persiste: O que a IA significa para a educação?

Na Jala University, uma instituição profundamente comprometida com a educação e o crescimento, estivemos ativamente envolvidos em trabalhar, pesquisar e desenvolver estratégias educacionais que aproveitam essa tecnologia. Como resultado, formamos nossas próprias opiniões sobre o assunto. Estamos confiantes de que ela tem um potencial profundo para remodelar tanto o desenvolvimento de software quanto a educação. Neste post do blog, vamos nos aprofundar nos aspectos mais importantes da IA Generativa e compartilhar nossas percepções sobre seu uso na educação. Vamos começar!

Entendendo a tendência

Enquanto a maioria dos usuários já está testemunhando as capacidades de aplicações como ChatGPT, Midjourney e Dall-e 3, transformando fluxos de trabalho diários com melhorias significativas de produtividade, a perspectiva de dentro do campo é ainda mais surpreendente.

Para aqueles diretamente envolvidos com IA Generativa, o ritmo de desenvolvimento é impressionante. Novos modelos, descobertas e avanços em ferramentas de infraestrutura e plataformas estão surgindo a uma taxa sem precedentes, com progressos notáveis ocorrendo quase semanalmente. Essa rápida evolução destaca não apenas o impacto imediato nas tarefas cotidianas, mas também o potencial de longo alcance do campo em um futuro não tão distante.

Para ilustrar o ritmo acelerado de desenvolvimento em IA Generativa, considere os avanços feitos no início de dezembro de 2023. O Google anunciou Gemini, um modelo multimodal inovador, desafiando o GPT-4. Simultaneamente, a Mistral AI revelou Mixtral 8x7b-32k, o primeiro modelo de ‘mistura de especialistas’ de código aberto, por meio de um tweet enigmático.

A Together AI lançou o StripedHyena-7B, um modelo muito competente que se desvia da arquitetura tradicional de transformadores. Além disso, pesquisadores de Cornell introduziram ‘QuIP#’, uma técnica para comprimir modelos de 16 bits em representações de 2 bits com perda mínima de desempenho. Estes desenvolvimentos, apenas uma amostra do progresso semanal contínuo, destacam a evolução dinâmica do campo.

Termos como “multimodal”, “transformadores”, “mistura de especialistas” e “quantização” podem ser novos para alguns leitores. Para tornar nossa discussão mais acessível, vamos focar no básico. Então, vamos começar com uma pergunta fundamental: O que é IA Generativa?

Entendendo a IA Generativa

IA Generativa refere-se a sistemas de inteligência artificial que podem gerar novo conteúdo.

Isso inclui tudo, desde escrever texto, compor música até gerar imagens ou vídeos realistas. Um avanço significativo nesse campo veio com o advento das arquiteturas baseadas em transformadores e técnicas de aprendizado profundo, que melhoraram muito as capacidades e a eficiência desses sistemas de IA.

Quando nos referimos exclusivamente a texto, usamos o termo Modelos de Linguagem de Grande Escala ou LLMs. Por exemplo, o GPT-4 é um modelo de linguagem de grande escala. Assim são os modelos LLaMA (desenvolvidos pela Meta), Claude-2 (desenvolvido pela Anthropic), PaLM-2 (desenvolvido pelo Google), Mistral (desenvolvido pela Mistral AI) e tantos outros que atualmente competem pelos lugares mais altos nas arenas de Chatbots.

Eles são chamados de grandes, porque sua arquitetura de aprendizado profundo consiste em algo que se assemelha a uma vasta rede de conexões neurais, semelhante a um modelo simplificado do cérebro humano. Essas redes, compostas por bilhões de parâmetros, são treinadas com um objetivo aparentemente simples: Prever o próximo token.

A fase de treinamento para um LLM competitivo é cara e muito desafiadora. Para uma boa introdução, você pode conferir o vídeo no YouTube de Andrej Karpathy “Intro to Large Language Models”.

No entanto, no seu núcleo, um LLM consiste em:

- Uma representação comprimida do mundo, derivada de seus dados de texto de treinamento.

- Um preditor do próximo token altamente eficaz.

Essas duas capacidades tornam os LLMs ferramentas eficientes de recuperação de conhecimento. Isso é verdade desde que o conhecimento estivesse presente em seu corpus de aprendizagem e não fosse diluído ou inconsistente.

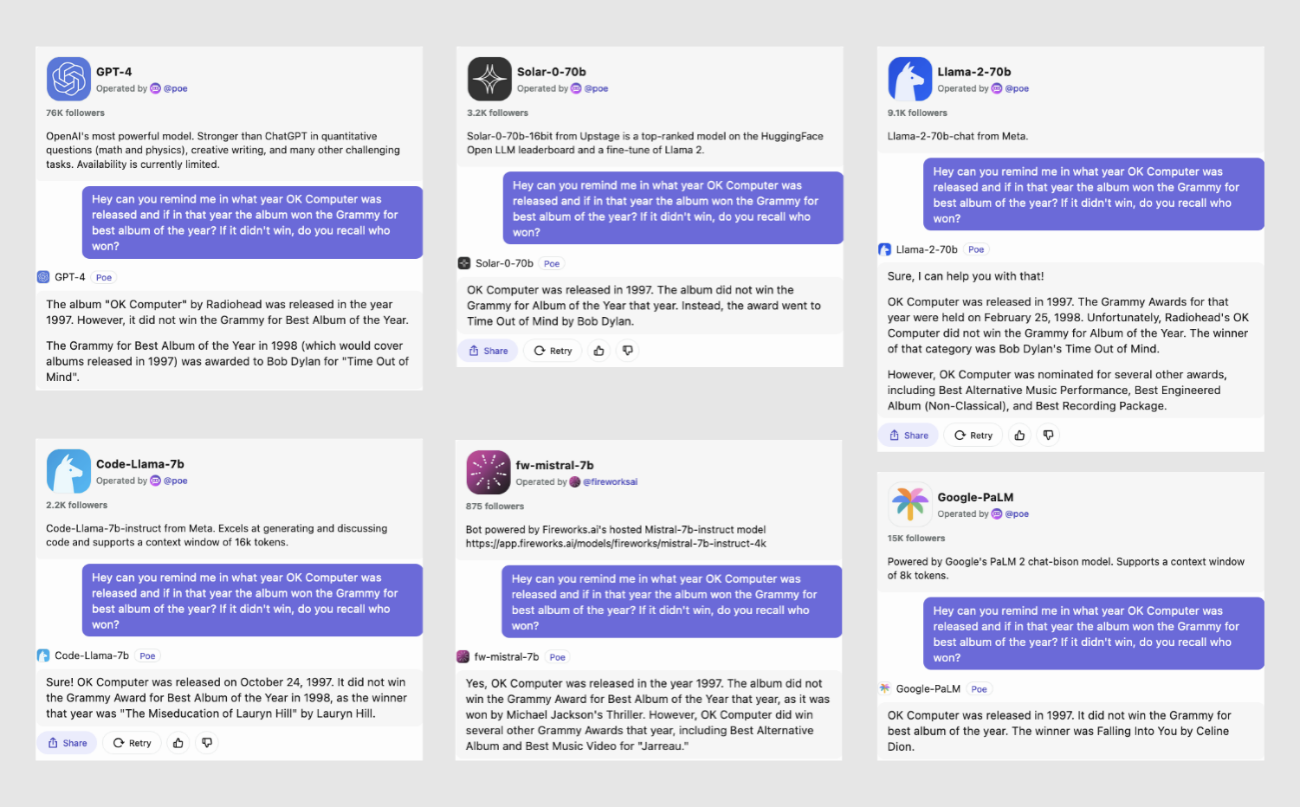

Quando avaliamos o desempenho de vários modelos de IA fazendo a pergunta “qual foi o ano de lançamento do ‘OK Computer’ do Radiohead?, e o prêmio Grammy daquele ano?”, obtivemos alguns resultados interessantes:

A maioria dos modelos identificou corretamente 1997 como o ano de lançamento. Os três principais modelos – GPT-4, Solar e Llama-2-70B – também observaram corretamente que Bob Dylan ganhou o Grammy de Melhor Álbum naquele ano. No entanto, com exceção do GPT-4, a maioria dos modelos demonstrou imprecisões ou confusão de fatos ao fornecer informações históricas adicionais, ilustrando os desafios em alcançar uma consistência factual perfeita nas respostas da IA.

A segunda capacidade que podemos observar é que os modelos são, às vezes, sonhadores!

Como são treinados basicamente para prever o próximo token e possuem uma versão compactada do mundo, eles geram conclusões plausíveis para os prompts. Por um lado positivo, essa característica destaca o aspecto imaginativo da IA.

Acontece que alguns desses modelos, em particular o GPT-4, mas também modelos como Mistral, Starcoder, Replit, Phind, CodeLlama e outros, são muito bons em programação. E por muito bons, queremos dizer que eles não apenas entendem e depuram códigos complexos, mas também escrevem programas funcionais e eficientes em vários idiomas.

Eles demonstram a capacidade de compreender conceitos de programação, seguir estruturas lógicas e até oferecer soluções de codificação criativas que podem rivalizar com programadores humanos experientes.

Portanto, esses tipos de IA se tornaram ferramentas muito úteis em nosso cotidiano. Mas o que isso significa para o futuro da educação? O desafio apresentado aqui não é apenas discernir se algo foi feito por estudantes ou por IA, mas também considerar se é necessário aprender essas habilidades no mundo de hoje.

A perspectiva da Jala sobre IA generativa

Da nossa posição na Jala, com uma sólida experiência em desenvolvimento de software e educação de mais de duas décadas, reconhecemos a importância crítica de compreender o impacto da IA generativa.

A Universidade Jala, um pilar em nossa visão, representa nosso compromisso com aqueles que confiam em nós para sua educação e com nossa região. Nesse contexto, entender como a IA generativa remodelará tanto a indústria de software quanto o cenário educacional não se torna apenas relevante, mas essencial para nós.

Ao longo do último ano (2023), vimos vislumbres do enorme potencial que essa tecnologia traz para o processo de desenvolvimento de software. Nossos engenheiros de software aprenderam a abraçar as ferramentas e usá-las de maneira responsável para maximizar sua produtividade. Também vivenciamos muitas dificuldades e testemunhamos a frustração de instrutores e alunos quando a tecnologia parecia estar se voltando contra nós.

Então, após uma longa introdução e sem querer ser muito especulativo sobre o que o futuro pode trazer, queremos compartilhar percepções-chave que encapsulam nossa posição sobre IA generativa.

1. A IA generativa veio para ficar; educadores e alunos devem abraçá-la proativamente.

É importante expor nossos alunos à tecnologia o mais cedo possível (idealmente durante o primeiro semestre).

2. Nós (Universidade) devemos reequilibrar ligeiramente nossos resultados de aprendizagem em direção a habilidades centradas no humano (pessoas).

Ao longo dos últimos 20 anos, nossa jornada educacional foi marcada por uma mudança dos modelos tradicionais focados em memorização e repetição, para nutrir habilidades de pensamento crítico e resolução de problemas.

À medida que caminhamos (ou corremos) em direção a um mundo onde a IA generativa complementa nossas habilidades diariamente, as habilidades de conhecimento serão menos relevantes, e as habilidades centradas no humano serão significativamente mais importantes.

Já estamos muito alinhados com esse caminho, mas devemos dobrar nossos esforços para que nossos alunos possam maximizar suas habilidades em pensamento crítico, colaboração, comunicação, resiliência, resolução de problemas, criatividade, inteligência emocional e a busca pelo aprendizado contínuo.

Paradoxalmente, a IA generativa pode nos ajudar ou jogar contra.

3. Aproveitar as ferramentas de IA generativa para alcançar nossos resultados de aprendizado dos alunos.

Concretamente:

a. Explorar e implementar aprendizado personalizado usando Tutores de IA que podem complementar a experiência de aprendizagem em nossos cursos enquanto se adaptam às forças, fraquezas, interesses e estilos de aprendizado de cada aluno.

b. Explorar e implementar suporte de tradução de idiomas em tempo real altamente eficiente, reduzindo a lacuna de comunicação que às vezes encontramos entre falantes nativos de inglês, espanhol e português.

c. Explorar e implementar sistemas de feedback automatizados de IA.

d. Garantir que a tecnologia seja acessível e disponível para estudantes e educadores.

4. Reavaliação e Adaptação Contínuas.

Revisitar e reavaliar regularmente nossas estratégias educacionais para garantir que permaneçam alinhadas com os últimos desenvolvimentos em IA generativa. Isso envolve adaptar nosso currículo, metodologias de ensino e ferramentas para permanecer na vanguarda das práticas educacionais impulsionadas pela IA.

Conclusão

Nosso compromisso com a educação e com nossa região é mais forte do que nunca. Nossa jornada com IA generativa está apenas começando, e antecipamos uma maior integração dessas tecnologias para aprimorar o aprendizado e a pesquisa. Juntos, entramos em uma nova era da educação na Jala University, prontos para inovar e liderar em um mundo aumentado pela IA.

Este artigo foi aprimorado com insights e assistência de revisão de modelos de IA de fronteira, incluindo o GPT-4 da OpenAI e o Claude-2 100K da Anthropic.

Este artigo foi escrito em inglês e traduzido para o português brasileiro com GPT-4.