¿La IA y la Educación son una buena combinación? La perspectiva de Jala University

Por Rolando Lora, del equipo de Research and Development de Jala University

La IA generativa ha dominado las conversaciones durante el último año, evocando un espectro de sentimientos desde el escepticismo hasta una mezcla de optimismo y pesimismo. Al reflexionar sobre el año pasado, se hace evidente que el mundo ha sido testigo de las aplicaciones prácticas y los efectos de largo alcance de la Inteligencia Artificial en varios aspectos de nuestras vidas.

En medio de esta evolución tecnológica, persiste una pregunta: «¿Qué significa la IA para la educación?»

En Jala University, una institución profundamente comprometida con la educación y el crecimiento, hemos estado activamente involucrados en trabajar, investigar y desarrollar estrategias educativas que aprovechan esta tecnología. Como resultado, hemos formado nuestras propias opiniones al respecto. Estamos seguros de que tiene un potencial profundo para remodelar tanto el desarrollo de software como la educación. En esta publicación de blog, abordaremos los aspectos más importantes de la IA Generativa y compartiremos nuestras ideas sobre su uso en la educación. ¡Empecemos!

Entendiendo la tendencia

Mientras que la mayoría de los usuarios ya están presenciando las capacidades de aplicaciones como ChatGPT, Midjourney y Dall-e 3, transformando los flujos de trabajo diarios con mejoras significativas en la productividad, la perspectiva desde dentro del campo es aún más asombrosa.

Para aquellos directamente involucrados en la IA Generativa, el ritmo de desarrollo es impresionante. Nuevos modelos, avances y mejoras en herramientas de infraestructura y plataformas están emergiendo a una tasa sin precedentes, con progresos notables ocurriendo casi semanalmente. Esta rápida evolución destaca no solo el impacto inmediato en las tareas cotidianas, sino también el potencial de largo alcance del campo en un futuro no tan lejano.

Para ilustrar el rápido ritmo de desarrollo en la IA Generativa, consideremos los avances realizados a principios de diciembre de 2023. Google anunció Gemini, un modelo multimodal revolucionario, desafiando a GPT-4. Al mismo tiempo, Mistral AI presentó Mixtral 8x7b-32k, el primer modelo de ‘mezcla de expertos’ de código abierto, a través de un tweet críptico.

Together AI lanzó StripedHyena-7B, un modelo muy competente que se desvía de la arquitectura tradicional de transformadores. Además, investigadores de Cornell introdujeron ‘QuIP#’, una técnica para comprimir modelos de 16 bits a representaciones de 2 bits con una mínima pérdida de rendimiento. Estos desarrollos, solo una instantánea del progreso semanal en curso, destacan la evolución dinámica del campo.

Términos como «multimodal», «transformadores», «mezcla de expertos» y «cuantización» pueden ser nuevos para algunos lectores. Para hacer nuestra discusión más accesible, vamos a reducir nuestro enfoque a lo básico. Así que, comencemos con una pregunta fundamental: ¿Qué es la IA Generativa?

Entendiendo la IA Generativa

La IA Generativa se refiere a los sistemas de inteligencia artificial que pueden generar nuevo contenido.

Esto incluye desde escribir texto, componer música, hasta generar imágenes o videos realistas. Un avance significativo en este campo vino con la llegada de arquitecturas basadas en transformadores y técnicas de aprendizaje profundo, que han mejorado enormemente las capacidades y la eficiencia de estos sistemas de IA.

Cuando nos referimos únicamente a texto, utilizamos el término Modelos de Lenguaje Grande o LLM (por sus siglas en inglés). Por ejemplo, GPT-4 es un modelo de lenguaje grande. También lo son los modelos LLaMA (desarrollados por Meta), Claude-2 (desarrollado por Anthropic), PaLM-2 (desarrollado por Google), Mistral (desarrollado por Mistral AI) y muchos otros que actualmente compiten por los primeros lugares en las arenas de Chatbots.

Se les llama grandes, porque su arquitectura de aprendizaje profundo consiste en algo que se asemeja a una vasta red de conexiones neuronales, similar a un modelo simplificado del cerebro humano. Estas redes, compuestas por miles de millones de parámetros, se entrenan con un objetivo aparentemente simple: Predecir el siguiente token.

La etapa de entrenamiento para un LLM competitivo es costosa y muy desafiante. Para una buena introducción, puedes consultar el video de Youtube de Andrej Karpathy «Intro to Large Language Models».

Sin embargo, en su núcleo, un LLM consiste en:

- Una representación comprimida del mundo, derivada de sus datos de texto de entrenamiento.

- Un predictor del siguiente token altamente efectivo.

Estas dos capacidades hacen que los LLM sean herramientas eficientes de recuperación de conocimiento. Esto es cierto siempre que el conocimiento estuviera presente en su corpus de aprendizaje y no estuviera diluido ni fuera inconsistente.

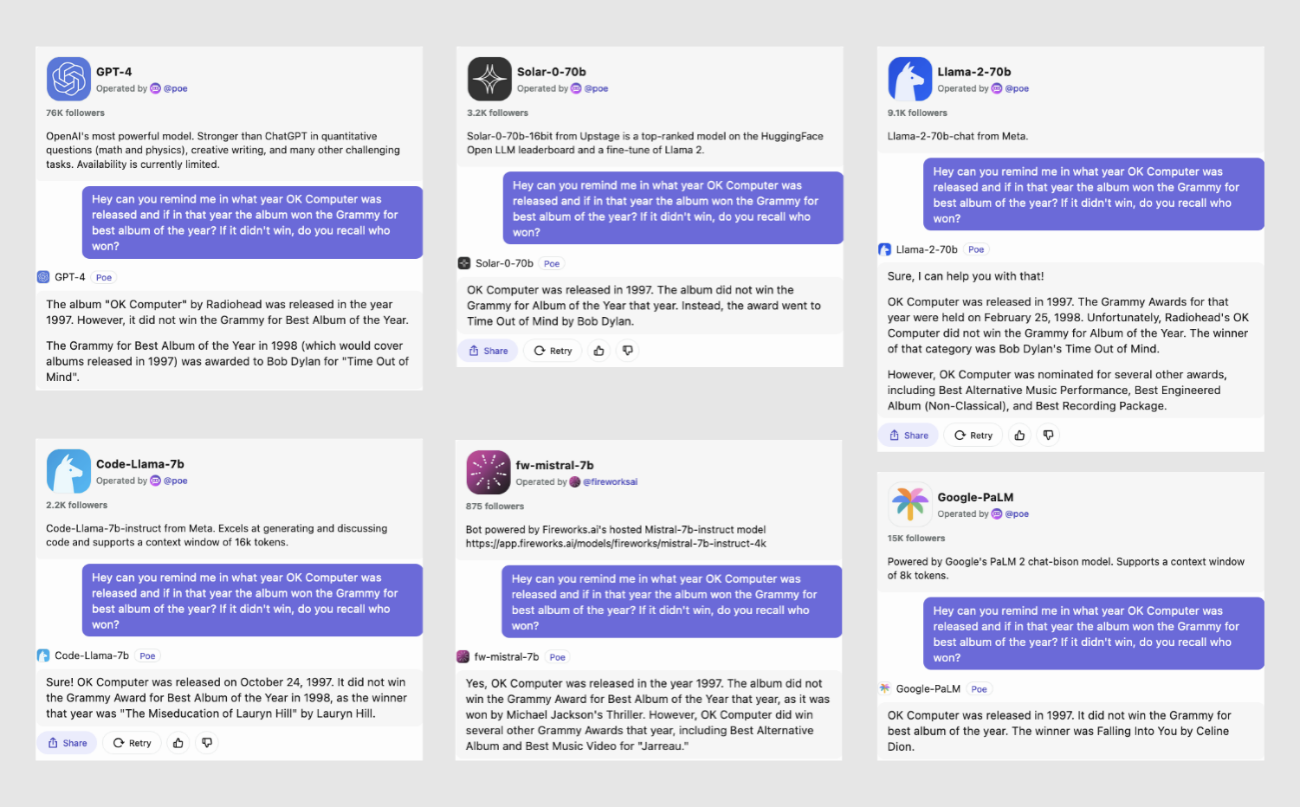

Cuando evaluamos el rendimiento de varios modelos de IA preguntándoles «¿cuál fue el año de lanzamiento del ‘OK Computer’ de Radiohead, y el Premio Grammy de ese año?», obtuvimos algunos resultados interesantes:

La mayoría de los modelos identificaron correctamente 1997 como el año de lanzamiento. Los tres mejores modelos – GPT-4, Solar y Llama-2-70B – también señalaron con precisión que Bob Dylan ganó el Grammy al Mejor Álbum ese año. Sin embargo, con la excepción de GPT-4, la mayoría de los modelos demostraron inexactitudes o confusión al proporcionar información histórica adicional, ilustrando los desafíos para lograr una consistencia factual perfecta en las respuestas de la IA. La segunda capacidad que podemos observar es que ¡a veces los modelos son soñadores!

La segunda capacidad que podemos observar es que ¡a veces los modelos son soñadores!

Dado que están entrenados para predecir básicamente el siguiente token y tienen una versión comprimida del mundo, generarán completaciones de indicaciones que parecen plausibles. Por el lado positivo, este rasgo subraya el aspecto imaginativo de la IA.

Resulta que algunos de estos modelos, en particular GPT-4, pero también modelos como Mistral, Starcoder, Replit, Phind, CodeLlama y otros, son muy buenos codificando. Y con muy buenos, queremos decir que no solo pueden entender y depurar código complejo, sino también escribir programas funcionales y eficientes en varios idiomas.

Demuestran una capacidad para comprender conceptos de programación, seguir estructuras lógicas e incluso ofrecer soluciones de codificación creativas que pueden competir con programadores humanos experimentados.

Por lo tanto, estos tipos de IA se han convertido en herramientas muy útiles en nuestra vida cotidiana. Pero, ¿qué significa esto para el futuro de la educación? El desafío presentado aquí no es solo discernir si algo ha sido hecho por estudiantes o por IA, sino también considerar si es necesario aprender estas habilidades en el mundo de hoy.

La postura de Jala sobre la IA Generativa

Desde nuestra posición en Jala, con una sólida experiencia en desarrollo de software y educación de más de dos décadas, reconocemos la importancia crítica de entender el impacto de la IA Generativa.

La Universidad Jala, piedra angular en nuestra visión, representa nuestro compromiso con aquellos que confían en nosotros para su educación y con nuestra región. En este sentido, entender cómo la IA Generativa remodelará tanto la industria del software como el paisaje educativo se convierte no solo en relevante, sino esencial para nosotros.

Durante el pasado año (2023), vimos vislumbres del enorme potencial que esta tecnología aporta al proceso de desarrollo de software. Nuestros ingenieros de software aprendieron a abrazar las herramientas y a utilizarlas de manera responsable para maximizar su productividad. También experimentamos muchos dolores y presenciamos la frustración de entrenadores y estudiantes cuando la tecnología parecía volverse contra nosotros.

Así que, después de una larga introducción, y sin tratar de ser demasiado especulativos sobre lo que el futuro pueda traer, queremos compartir puntos clave que encapsulan nuestra posición sobre la IA Generativa.

1. La IA Generativa ha llegado para quedarse, educadores y estudiantes deben abrazarla de manera proactiva.

Es importante exponer a nuestros estudiantes a la tecnología lo antes posible (idealmente durante el primer semestre).

2. Nosotros (Universidad) debemos reequilibrar ligeramente nuestros resultados estudiantiles hacia habilidades centradas en el humano (personas).

Durante los últimos 20 años, nuestro viaje educativo ha estado marcado por un cambio desde modelos tradicionales enfocados en la memorización y repetición, hacia el fomento del pensamiento crítico y habilidades de resolución de problemas.

A medida que avanzamos (o corremos) hacia un mundo donde la IA Generativa complementa nuestras habilidades diariamente, las habilidades de conocimiento serán menos relevantes, y las habilidades centradas en el humano serán significativamente más importantes.

Ya estamos muy alineados con este camino, pero debemos doblar nuestros esfuerzos para que nuestros estudiantes puedan maximizar sus habilidades en pensamiento crítico, colaboración, comunicación, resiliencia, resolución de problemas, creatividad, inteligencia emocional y la búsqueda del aprendizaje continuo.

Paradójicamente, la IA Generativa puede ayudarnos o jugar en contra.

3. Aprovechar las herramientas de IA Generativa para lograr nuestros resultados estudiantiles.

Concretamente:

a. Explorar e implementar el aprendizaje personalizado usando Tutores IA que pueden complementar la experiencia de aprendizaje en nuestros cursos mientras se adaptan a las fortalezas, debilidades, intereses y estilos de aprendizaje de cada estudiante.

b. Explorar e implementar soporte de traducción de idiomas en tiempo real altamente eficiente reduciendo la brecha de comunicación que a veces encontramos entre hablantes nativos de inglés, español y portugués.

c. Explorar e implementar sistemas automáticos de retroalimentación de IA.

d. Asegurar que la tecnología sea accesible y disponible para estudiantes y educadores.

4. Reevaluación y Adaptación Continua.

Revisar y reevaluar regularmente nuestras estrategias educativas para asegurar que permanezcan alineadas con los últimos desarrollos en IA Generativa. Esto implica adaptar nuestro currículum, metodologías de enseñanza y herramientas para estar a la vanguardia de las prácticas educativas impulsadas por la IA.

Conclusión:

Nuestro compromiso con la educación y con nuestra región es más fuerte que nunca. Nuestro viaje con la IA Generativa apenas comienza, y anticipamos integrar aún más estas tecnologías para mejorar el aprendizaje y la investigación. Juntos, entramos en una nueva era de educación en la Universidad Jala, listos para innovar y liderar en un mundo aumentado por la IA.

Este artículo fue mejorado con ideas y asistencia de revisión de modelos de IA fronterizos, incluyendo GPT-4 de OpenAI y Claude-2 100K de Anthropic.

Este artículo fue escrito en inglés y traducido al español latinoamericano con GPT-4